Co tam u mojego GeForsika pożerającego całe setki watów? Wszystko dobrze?

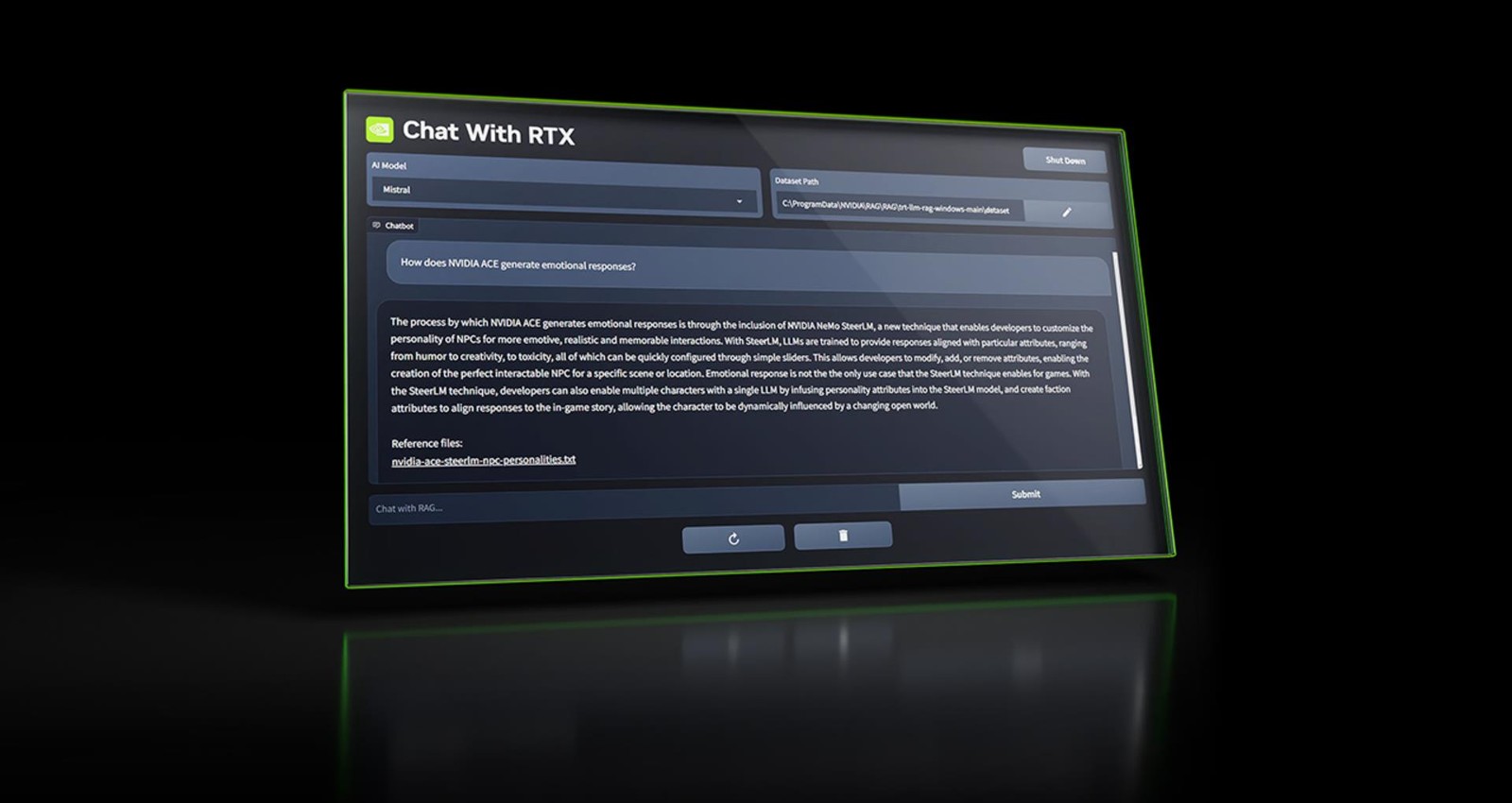

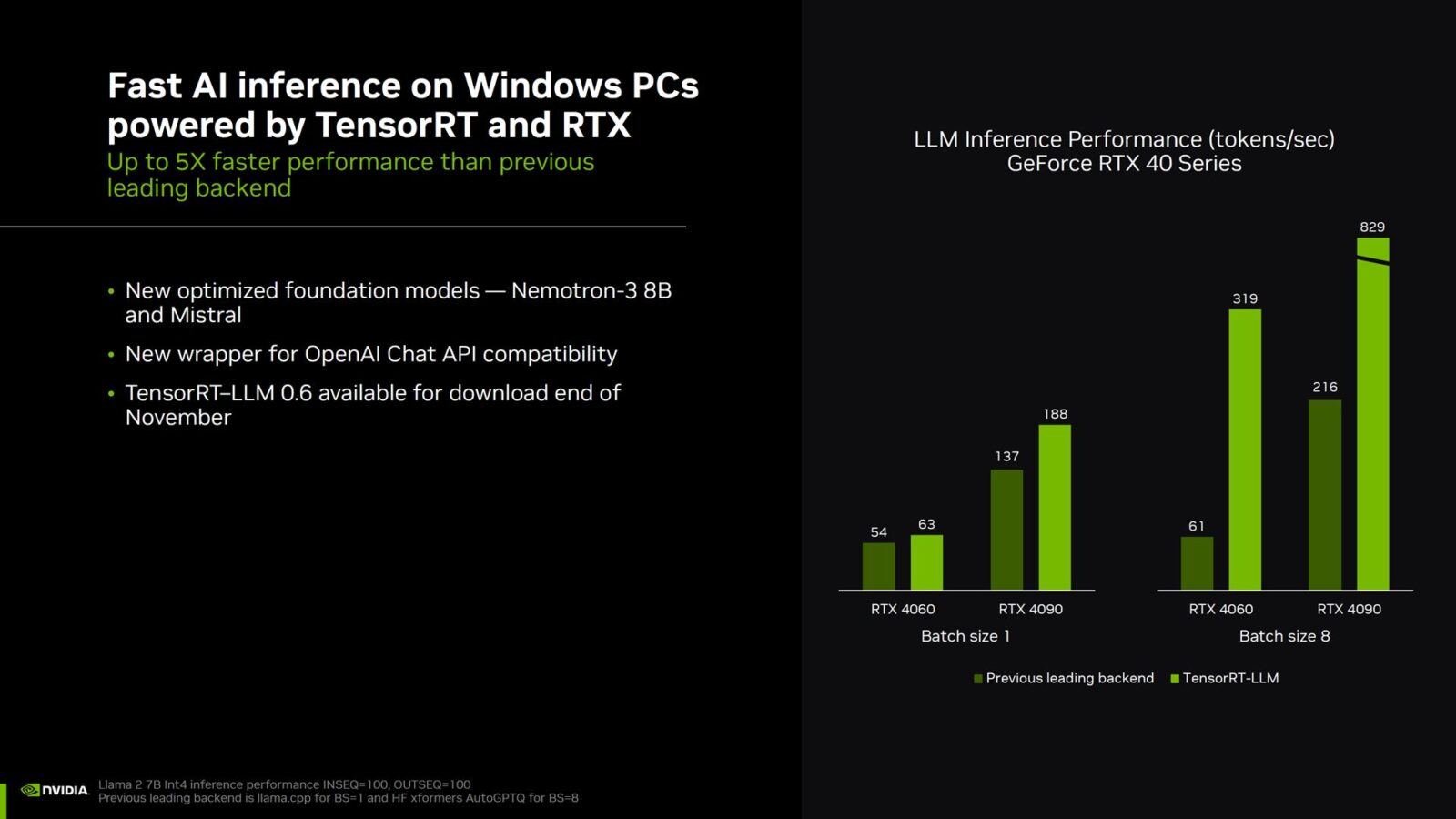

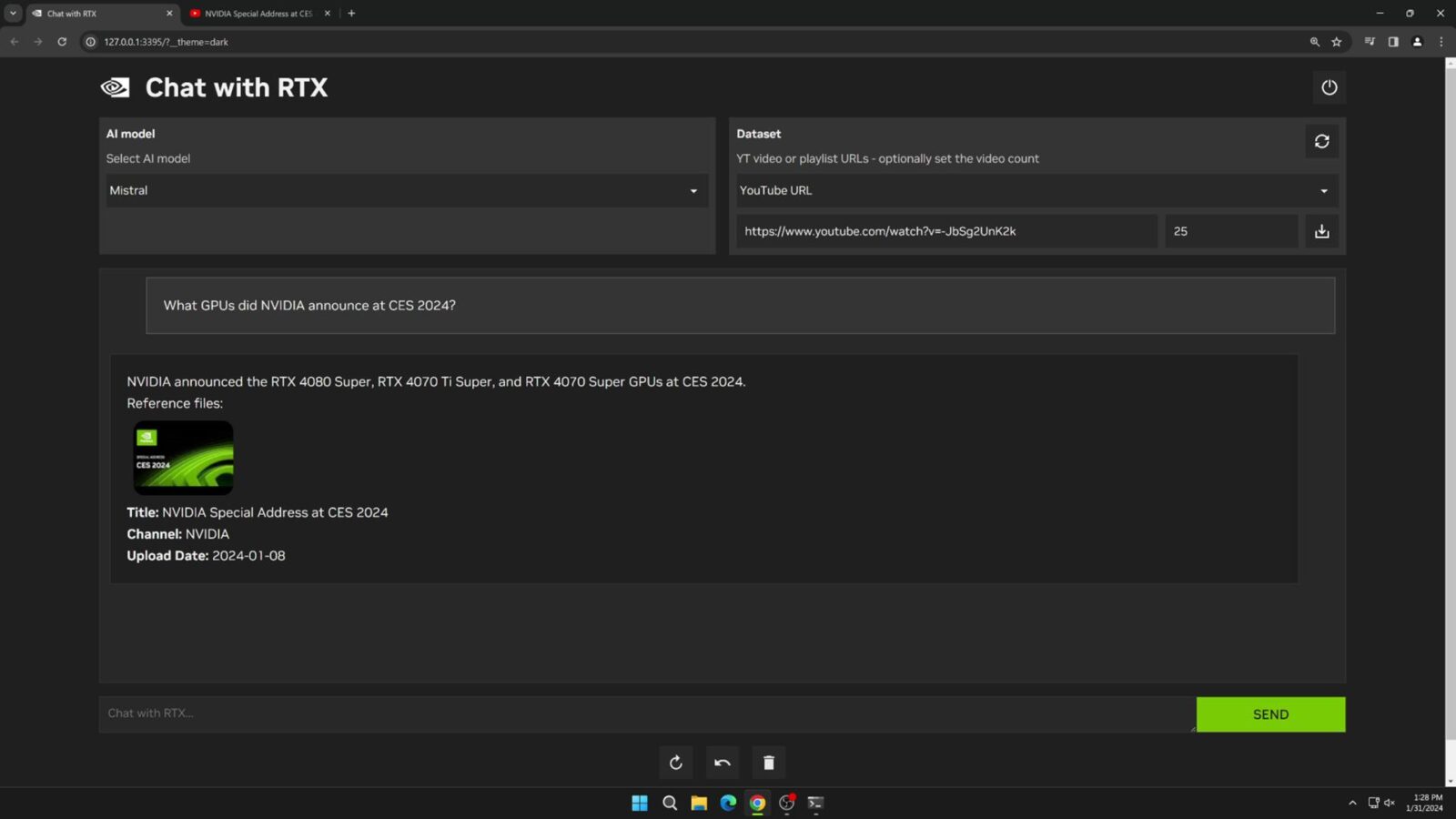

Chat with RTX jest już dostępny dla komputerów z systemem Windows za darmo. Jego działanie oparto o TensorRT-LLM i Retrieval Augmented Generated (RAG), a jako że działa całkowicie lokalnie, czyli nie “z serwera” wymaga do pracy jedynie karty graficznej z serii GeForce RTX 4000 lub RTX 3000 z przynajmniej 8 GB pamięci VRAM. Oznacza to, że możecie być całkowicie offline, a rozmowa z takim chatem będzie w pełni możliwa. Ba, będzie można nawet zaprojektować własnego chatbota, bo Chat with RTX można w pełni spersonalizować, wykorzystując zestaw danych dostępny lokalnie na komputerze i potraktować go, jako prywatną wyszukiwarkę/asystenta.

Czytaj też: Nvidia ma powody do zadowolenia. Reflex wspiera już ponad 100 gier

Po pobraniu Chat with RTX (o tutaj) użytkownicy mogą połączyć go z lokalnym zbiorem danych dostępnym na komputerze w tradycyjnych formatach, a następnie połączyć go z dużym modelem językowym (Llama 2 lub Mistral). W efekcie można uzyskać chatbota, który będzie operował wyłącznie na konkretnym zbiorze danych, a nie wszystkim, co pożarł podczas nauki albo wyszukał w sieci. Nie jest to oczywiście pierwsze tego typu narzędzie na rynku, ale NVIDIA po prostu sprawiła, że stało się bardziej dostępne i przyjemniejsze w konfiguracji oraz użyciu.