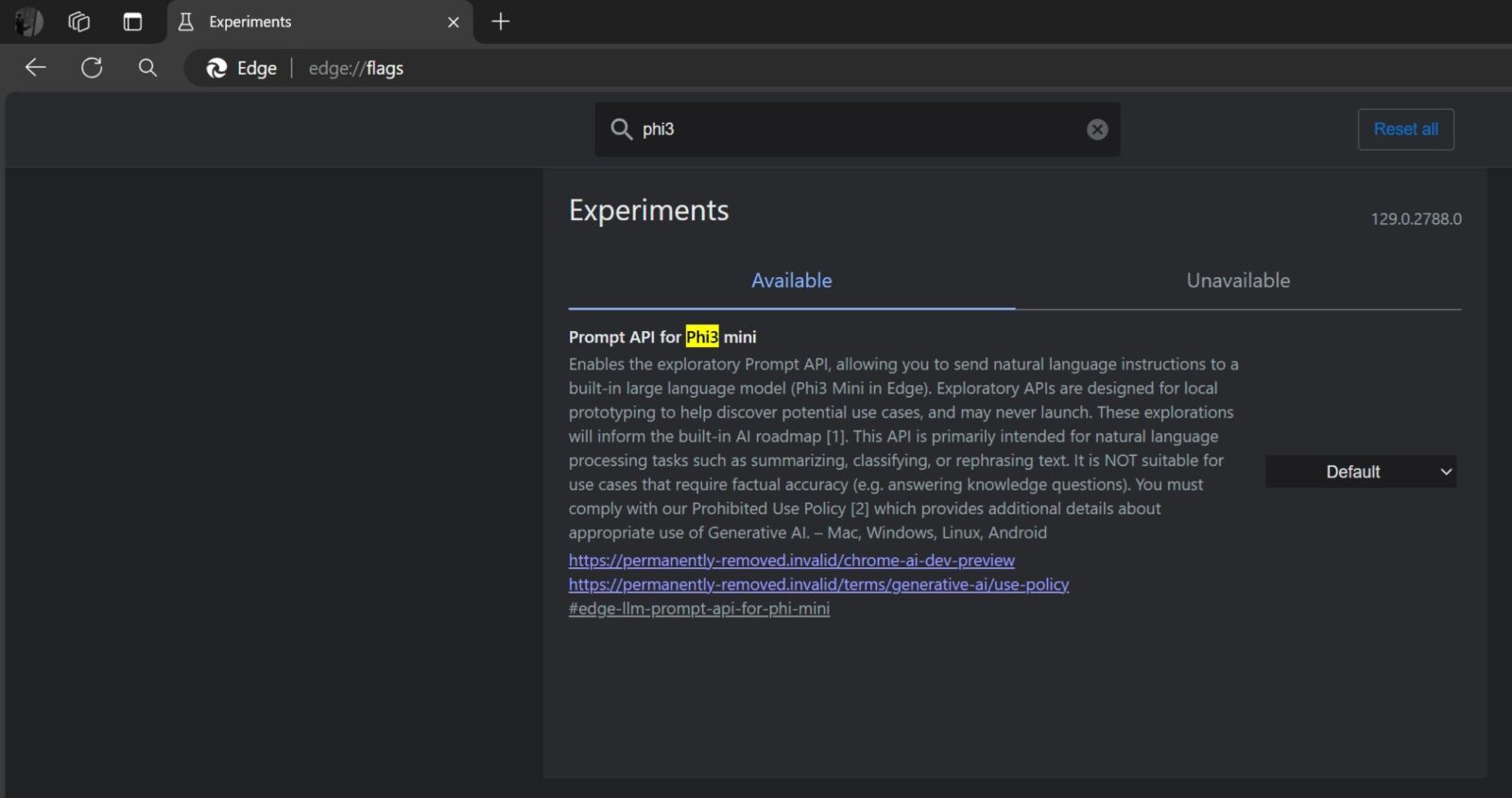

Skąd wiemy o takich próbach? Wykryto je w eksperymentalnych flagach zauważonych w edycji Edge Canary, czyli tam, gdzie wprowadza się nowości jeszcze na długo przed wdrożeniem ich do edycji beta. Flaga nazywa się “Prompt API for Phi3 min” i pozwala na włączenie eksploracyjnego interfejsu API z wbudowanym modelem językowym.

Co da Phi3 Mini AI w Edge?

Po jej włączeniu uruchamia się interfejs API Prompt, umożliwiający wysyłanie instrukcji w języku naturalnym do wbudowanego dużego modelu językowego, czyli Phi3 Mini. Można wpisywać prompty w celu wykonywania zadań związanych z przetwarzaniem języka naturalnego, takich jak podsumowywanie, klasyfikowanie lub przekształcanie tekstu. Microsoft w opisie flagi eksperymentalnej zaznacza, że nie nadaje się do przypadków użycia, które wymagają dokładności opartej na faktach (np. odpowiadania na pytania merytoryczne).

Pomysł modelu małego języka Edge’a jest nadal przedmiotem prac i prawdopodobnie znajduje się w bardzo początkowej fazie rozwoju. Nie jest też możliwe lokalne zaszycie dużego modelu językowego w przeglądarce, dlatego można powiedzieć, że mamy do czynienia z okrojonym. A w jaki sposób Microsoft mógłby zintegrować lokalną sztuczną inteligencję z Edge? Możesz na przykład wybrać kilkaset słów tekstu, kliknąć prawym przyciskiem myszy, a następnie użyć wbudowanego procesu Edge AI, aby lokalnie “podsumować lub przeformułować tekst”.

Czytaj też: Microsoft ma powody do zadowolenia. Edge zbliża się do 14% udziału w rynku

Po prawdzie żadna to duża nowość – podobne działania wykonuje Copilot. Jednak gdy dane są przetwarzane lokalnie, odpowiedzi są zazwyczaj szybsze i bardziej prywatne. Dodatkowo Microsoft wspomina o „lokalnym prototypowaniu”, co jest kolejnym wyraźnym sygnałem, że firma eksperymentuje z lokalnym hostingiem API. Oczywiście lokalnie uruchamiane modele AI w Edge to pomysł wymagający sporo pracy i można mieć nadzieję, że integracja nie pochłonie dużych zasobów systemowych.