Architektura dopasowana do wielkich wyzwań i praktyczne zastosowania nowej technologii

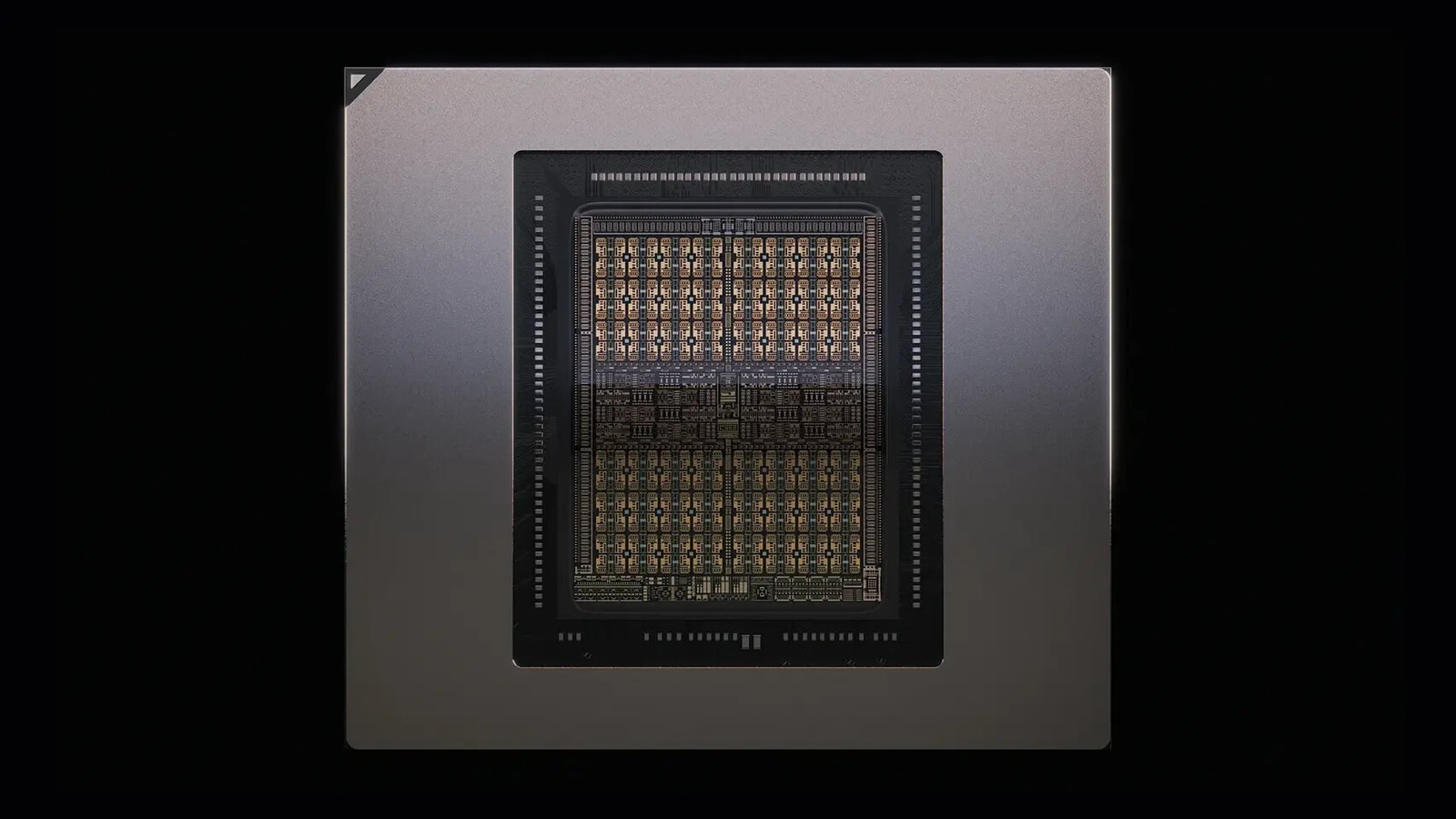

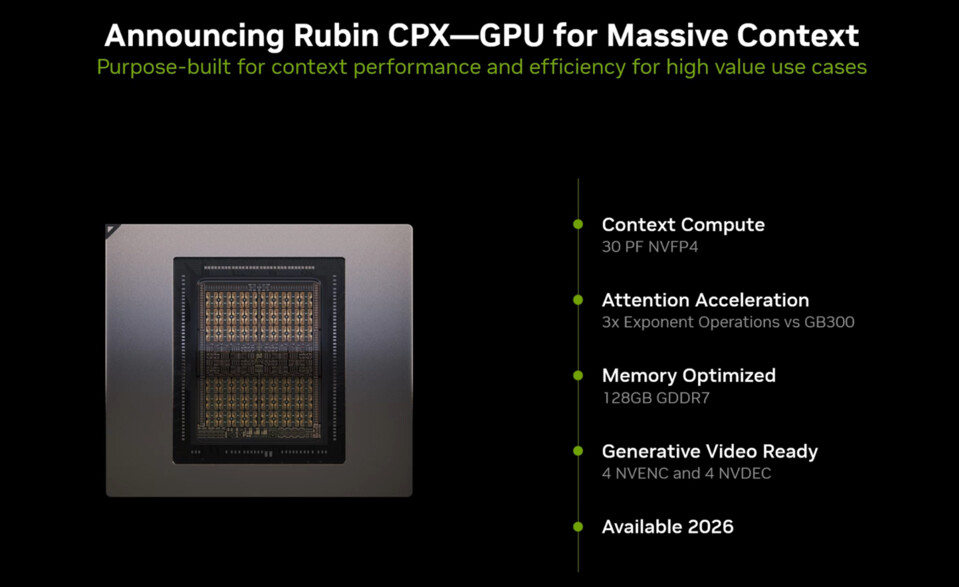

Rubin CPX wyróżnia się niestandardowym podejściem do konstrukcji. Firma zrezygnowała z dwuprocesorowych pakietów znanych z architektur Blackwell czy nadchodzącej rodziny Rubin na rzecz monolitycznej matrycy. Takie kosztowo zoptymalizowane rozwiązanie redukuje złożoność produkcji przy zachowaniu imponującej gęstości obliczeniowej.

Czytaj też: Xbox Cloud Gaming wkracza do samochodów. Partnerstwo z LG może zmienić podróże

Nowy procesor oferuje 30 petaflopów wydajności obliczeniowej w precyzji NVFP4 oraz 128 GB pamięci GDDR7. Co ciekawe, chip integruje bezpośrednio cztery enkodery wideo NVENC i cztery dekodery NVDEC, co eliminuje konieczność stosowania zewnętrznych rozwiązań do przetwarzania multimediów. Wydajność Rubin CPX w zadaniach związanych z przetwarzaniem uwagi jest trzykrotnie wyższa niż w przypadku obecnych systemów Blackwell Ultra GB300. To kluczowa przewaga, gdy model AI musi analizować całe bazy kodu liczące setki tysięcy linii lub przetwarzać godzinne materiały wideo.

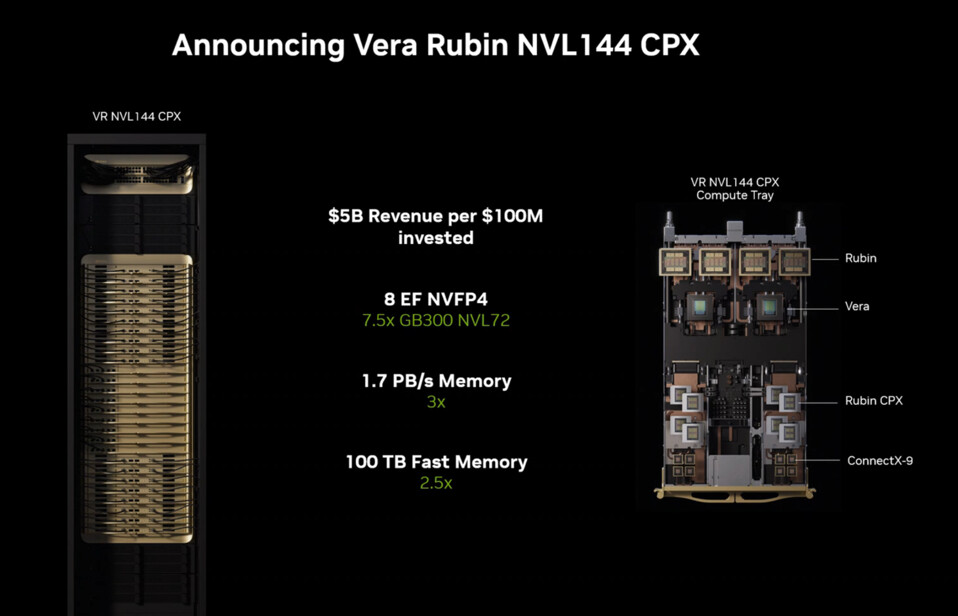

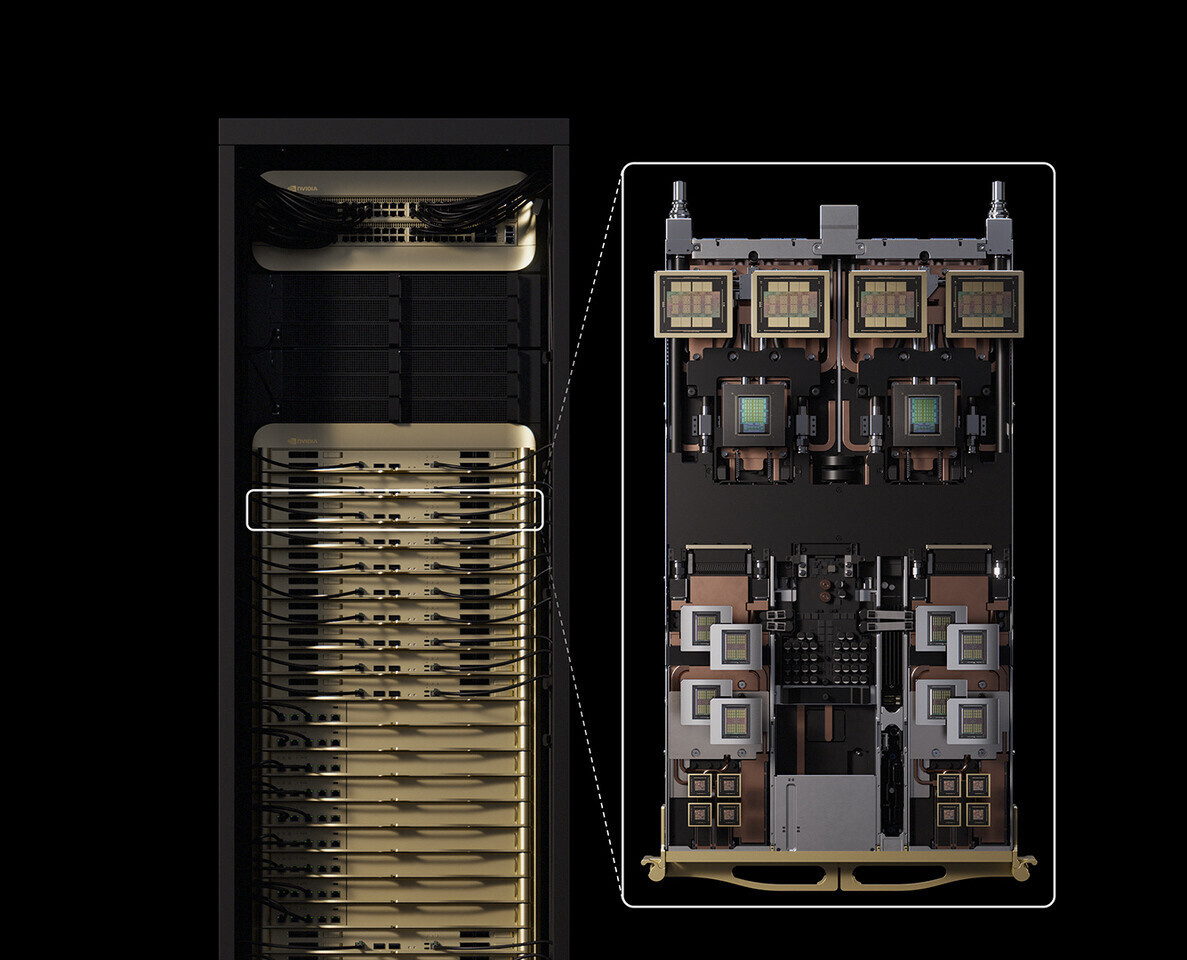

Nowy GPU nie będzie działał w pojedynkę, ponieważ grupa zielonych planuje jego integrację z platformą Vera Rubin NVL144 CPX, która łączy tradycyjne procesory Rubin z wyspecjalizowanymi wariantami CPX. Taka hybrydowa konfiguracja ma osiągnąć 8 exaflopów łącznej wydajności obliczeniowej. Kompletny system w jednej szafie rackowej zapewni przepustowość pamięci na poziomie 1,7 petabajta na sekundę oraz 100 TB szybkiej pamięci. To 7,5-krotnie lepsza wydajność AI niż obecne systemy GB300 NVL72.

Czytaj też: Arm prezentuje rdzenie C1 i GPU G1. Nowa generacja chipów w smartfonach już pod koniec 2025 roku

Pełne wdrożenie w racku Kyber obejmie również adaptery sieciowe ConnectX-9 obsługujące sieci 1600G oraz przełączanie Spectrum6 o przepustowości 102,4T. Nvidia szacuje, że firmy mogą osiągnąć 5 miliardów dolarów przychodu z tokenów za każde 100 milionów dolarów zainwestowane w systemy Vera Rubin NVL144 CPX.

Rubin CPX powstał z myślą o konkretnych zastosowaniach. Firmy takie jak Cursor, Runway czy Magic już testują możliwości nowej technologii. Cursor planuje wykorzystać GPU do szybkiego generowania kodu i analizy całych projektów programistycznych. Za to Runway dostrzega potencjał w tworzeniu dłuższych treści wideo z większą elastycznością i kontrolą twórczą. Magic chce natomiast wykorzystać 100-milionowe okna kontekstu do analizy całych baz kodu, lat historii interakcji oraz dokumentacji bez konieczności dodatkowego trenowania modeli.

Integracja enkoderów i dekoderów wideo bezpośrednio na chipie otwiera nowe możliwości w aplikacjach długoformatowych, takich jak wyszukiwanie w materiałach wideo czy generowanie wysokiej jakości treści multimedialnych. Rubin CPX reprezentuje istotną zmianę w podejściu do przetwarzania AI. Tradycyjne wnioskowanie składa się z dwóch faz: przetwarzania kontekstu i generowania odpowiedzi. Nowy GPU został zoptymalizowany pod pierwszą fazę, która staje się wąskim gardłem przy długich kontekstach przekraczających milion tokenów.

Czytaj też: Akko na IFA 2025. Kulturowa klawiatura i strategiczny ruch w technologii magnetycznej

Taka specjalizacja pozwala na znaczące przyspieszenie całego procesu. W niektórych aplikacjach AI użytkownicy czekają nawet 5-10 minut na pierwszą odpowiedź przy analizie 100 tysięcy linii kodu. Rubin CPX ma drastycznie skrócić ten czas. Dla istniejących systemów Vera Rubin NVL144 Nvidia oferuje dedykowaną tacę obliczeniową z procesorami CPX. Nowe instalacje otrzymają zintegrowaną platformę zwiększającą moc obliczeniową z 3,6 do 8 exaflopów i obsługującą do 150 TB szybkiej pamięci GDDR7.

Wprowadzenie Rubin CPX na rynek planowane jest na koniec 2026 roku, po debiucie regularnych GPU Rubin na początku tego samego roku. To może oznaczać początek nowej ery w rozwoju sztucznej inteligencji, gdzie modele będą mogły przetwarzać jeszcze większe ilości informacji jednocześnie, otwierając drogę do bardziej zaawansowanych systemów rozumowania i autonomicznych agentów AI.

Patrząc na te zapowiedzi, trudno nie odnieść wrażenia, że branża AI znów przyspiesza. Choć daty premiery sięgają 2026 roku, a historia pokazuje, że takie zapowiedzi często ulegają opóźnieniom, kierunek jest jasny. Potrzeba przetwarzania coraz większych kontekstów staje się kluczowa dla rozwoju bardziej zaawansowanych systemów.