Z HBM4 karty graficzne wejdą na zupełnie nieznany dotąd poziom

Niedawne doniesienia od DigiTimes, powołujące się na informacje z Seoul Economy, sugerują, że HBM4, czyli kolejna generacja pamięci o dużej przepustowości, ma na nowo zdefiniować potencjał jednostek przetwarzania grafiki (GPU) oraz dynamicznie rozwijający się sektor sztucznej inteligencji (AI). Co dokładnie to oznacza dla technologii i kiedy możemy spodziewać się tych postępów na rynku?

Czytaj też: Masz kartę GeForce i grasz w Starfielda? Mamy dla ciebie dobre informacje

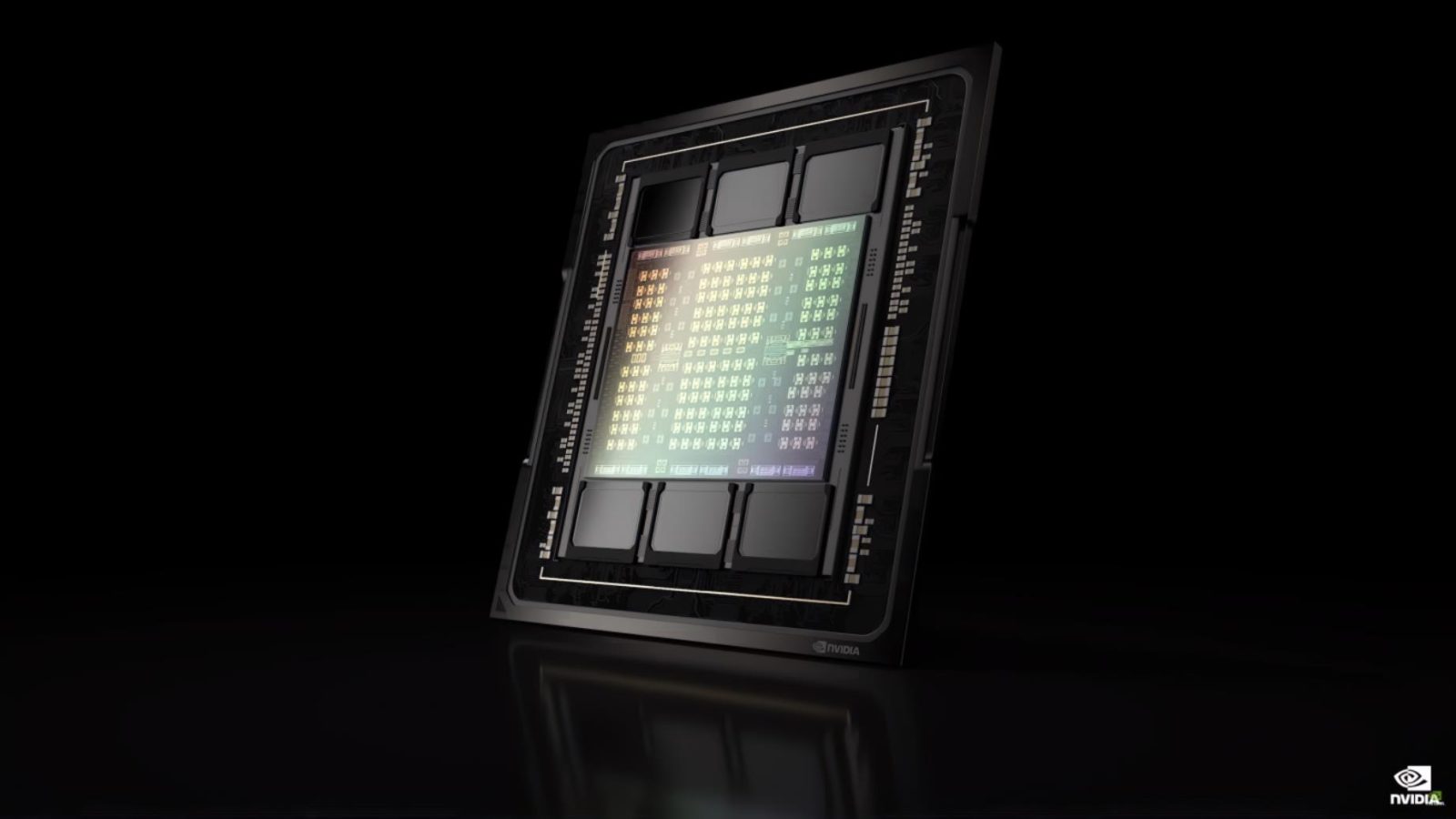

Wszystko sprowadza się do tego, że wedle oczekiwań magistrala HBM4 będzie aż 2048 bitowa, co oznacza, że w porównaniu do jej poprzedników przepustowość tej pamięci wzrośnie aż dwukrotnie (z 1,15 do 2,3 TB/s). Jest to o tyle przełomowe, że sektor High-Bandwidth Memory (HBM) nie doświadczył żadnych większych innowacji w interfejsie pamięci od 2015 roku. Przypomnijmy, że obecnie integracja HBM3e w najnowszych GPU przeznaczonych do obliczeń SI pochwalić się może przepustowością do 5 TB/s na chip, co znacząco poprawiło wydajność kart Nvidia H100.

Czytaj też: AMD oszalało? Nvidia na zawsze zostanie z koroną króla na rynku kart graficznych

Dzisiejsze plotki o HBM4 sugerują, że ten standard pamięci zaoferuje wykładniczo zwiększone możliwości obliczeniowe, a tym samym jeszcze lepsze wsparcie dla większych modeli językowych, czyli kluczowego elementu w postępie nowej generacji rozwoju genAI. Tyle tylko, że to dalsza, niż bliższa przyszłość, bo tak się składa, że HBM4 nie doczekała się jeszcze nawet oficjalnej specyfikacji czy standardu. Nic dziwnego, bo ledwie w zeszłym roku rozpoczęła się masowa produkcja HBM3 w fabrykach SK Hynix.